玩转 DeepSeek-R1 本地部署+知识库搭建+多轮RAG,保姆级教程!

UltraRAG 框架由清华大学 THUNLP 联合东北大学 NEUIR 、面壁智能团队及 9#AISoft 团队共同提出,基于敏捷化部署与模块化构造,引入了自动化的“数据构建-模型微调-推理评测”知识适配技术体系,提供了一站式、科研与开发双重友好的 RAG 系统解决方案。UltraRAG 显著简化了 RAG 系统在领域适配过程中,从数据构建到模型微调的全流程,助力科研人员与开发者高效应对复杂任务

最近,深度求索开源的 DeepSeek-R1 系列模型火遍全球,但因为“服务器繁忙”劝退不少人。为了解决这个问题,我们将以 UltraRAG 框架为例,为大家介绍 DeepSeek-R1 的本地部署流程,同时带领大家熟悉 UltraRAG 的细节和功能。在成功跑通 VanillaRAG 后,我们还简单尝试了在 DeepSeek-R1 加持下的 Adaptive-Note,提出法律领域的问题,效果居然出乎意料地好,有截图为证:

如上图,在 UltraRAG 上对 VanillaRAG 和 Adaptive-Note 分别提问“我喝多后撞了人可能会承担什么罪责?”VanillaRAG 简单直接,分别列出了罪名和建议,内容全面,但是稍微有点不够细致。再看看 Adaptive-Note 的回答,不光总结了可能的几点罪名,并且分析了酒精含量和事后处理态度对量刑和赔偿的影响,引经据典,令人信服。整体来看, Adaptive-Note 的回答更加可信。

VanillaRAG:是最基础的 RAG(Retrieval-Augmented Generation,检索增强生成)架构,通常指的是未经优化或改进的标准 RAG 方法。它的基本流程包括:查询构造(Query Formation)、检索(Retrieval)、生成(Generation)

Adaptive-Note: 一种用于复杂问答任务的自适应笔记增强 RAG 方法,采用 检索-记忆(Retriever-and-Memory) 机制, iteratively 收集和优化知识结构。它通过自适应记忆复审和任务导向生成提高知识交互质量,并采用基于笔记的探索终止策略确保信息充分获取,以提升答案质量。论文: https://arxiv.org/abs/2410.08821

看到这里,我猜大家已经迫不及待想要体验 UltraRAG 了,所以接下来我们将手把手详细介绍 UltraRAG 的部署流程。

硬件环境准备

DeepSeek-R1 的模型有多个蒸馏版本,分别是 7B、14B、70B 以及满血的 671B 版本。权衡了条件和效果后,我们选择 14B 的模型进行部署,以下是运行 UltraRAG 的基本硬件要求:

这里需要注意 nvidia 的显卡驱动需要和 cuda 版本兼容,否则 vllm 运行模型有可能出现报错的情况。如果你的显卡出现不兼容的情况,可以尝试重装驱动和 cuda。这里推荐一个简单好用的安装方法,可以有效避免 cuda 和驱动的不兼容问题:登录 nvidia 官方网站(https://developer.nvidia.com/cuda-toolkit-archive),选择适合 cuda-toolkit 版本安装和安装参数(推荐使用 runfile 方式安装,真的简单好用!)。

cuda-toolkit参数配置页面

cuda-toolkit参数配置页面

UltraRAG配置

好了,现在你已经拥有了一个稳定的运行环境,可以配置 UltraRAG 了。接下来从 GitHub 仓库中下载 UltraRAG 并放到合适的位置,https://github.com/OpenBMB/UltraRAG (点个 star 支持一下吧)。

运行 UltraRAG 有两种方法,一种通过 docker 运行,这种方式最简单,需要你的机器上已经安装配置好了 nvidia-docker ,并拥有它的运行的权限(一般情况下需要 root 权限)。这种情况下,你只需要执行这行代码就行了:

`docker-compose up --build -d`

如果你的机器上没有 nvidia-docker 也不要紧,可以配置 conda 环境来运行。

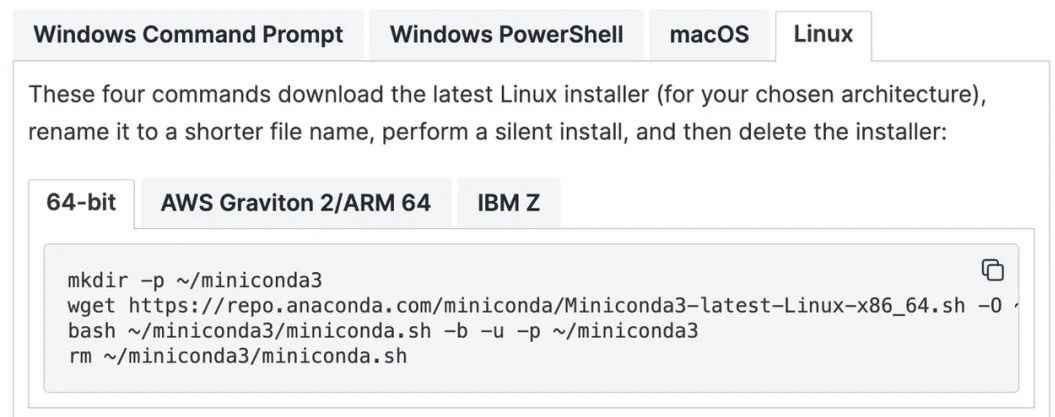

要确保你的本地机器安装了 conda,没有的话也可以在这个网址(https://docs.anaconda.com/miniconda/install/)中找到安装的方法,使用普通账户直接安装,几行代码很好执行~

接着,就是在 conda 环境上安装 UltraRAG 的依赖,下面的代码依次执行就好了~

`#创建conda环境conda` `create -n ultrarag python=3.10#激活conda环境conda activate ultrarag安装相关依赖pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple`

以上步骤操作完成之后,环境依赖就准备好了。接下来开始下载模型。

我们需要下载以下 3 个模型,分别执行命令。

模型下载完成之后,紧接着运行 llm 服务,具体执行这个命令即可~

`vllm serve DeepSeek-R1-Distill-Qwen-14B --gpu-memory-utilization 0.8 --dtype auto --api-key token-abc123`

这里简单说明一下参数的含义:

–gpu-memory-utilization 0.8:表示 GPU 的占用率,显存 80G 时,0.8 意味着最大占用 64GB 的显存。

–dtype auto:表示 vllm 自动选择模型参数类型。

–api-key token-abc123:自定义模型 API 的密钥为 token-abc123。

vllm 服务部署完成后将会启动 OpenAI-Compatibly 的服务,默认参数为:

为了常驻后台,你也可以使用以下命令运行:

nohup vllm serve DeepSeek-R1-Distill-Qwen-14B --gpu-memory-utilization 0.8 --dtype auto --api-key token-abc123 &

好了,现在环境搭好了,模型也下载好了,我们现在来运行 UltraRAG :

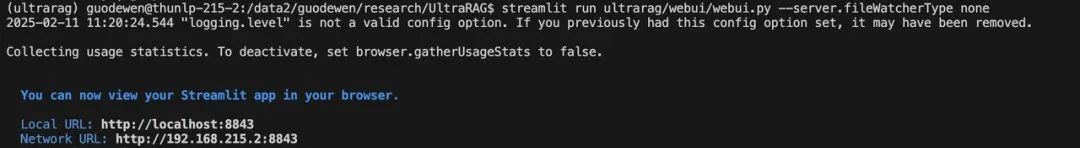

`streamlit run ultrarag/webui/webui.py --server.fileWatcherType none`

如果一切顺利,我们会看到下图的结果。这意味着 WebUI 已经跑起来了,我们把 URL 复制到浏览器,应该就能访问页面了,你可以使用 3 个 URL 中的任何一个进行访问:

和DeepSeek-R1对话

这里附上超详细视频教程,可以对照细节一步步上手:

什么是 UltraRAG?

UltraRAG 框架由清华大学 THUNLP 联合东北大学 NEUIR 、面壁智能团队及 9#AISoft 团队共同提出,基于敏捷化部署与模块化构造,引入了自动化的“数据构建-模型微调-推理评测”知识适配技术体系,提供了一站式、科研与开发双重友好的 RAG 系统解决方案。UltraRAG 显著简化了 RAG 系统在领域适配过程中,从数据构建到模型微调的全流程,助力科研人员与开发者高效应对复杂任务:

UltraRAG 框架具有以下优势:

零代码编程 WebUI 支持:零编程经验用户亦可上手操作全链路搭建和优化过程,包括多模态 RAG 方案 VisRAG ;

合成与微调一键式解决:以自研 KBAlign、RAG-DDR 等方法为核心,一键式系统化数据构建 + 检索、生成模型多样微调策略支持下的性能优化;

多维多阶段稳健式评估:以自研 RAGEval 方法为核心,融入面向有效/关键信息的多阶段评估方法,显著提升“模型评估”的稳健性;

科研友好探索工作集成:内置 THUNLP-RAG 组自研方法及其他前沿 RAG 方法,支持模块级持续探索与研发。

以上全部功能,都可以直接通过 web 前端快速实现。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)