变分自动编码器:从理论到实践

1.背景介绍自动编码器(Autoencoders)是一种神经网络架构,它可以用于降维、数据压缩和生成等任务。变分自动编码器(Variational Autoencoders,VAE)是一种特殊类型的自动编码器,它采用了变分推断(Variational Inference)技术,以估计数据的隐藏状态。在这篇文章中,我们将深入探讨 VAE 的理论基础、核心概念、算法原理以及实际应用。我们还将讨...

1.背景介绍

自动编码器(Autoencoders)是一种神经网络架构,它可以用于降维、数据压缩和生成等任务。变分自动编码器(Variational Autoencoders,VAE)是一种特殊类型的自动编码器,它采用了变分推断(Variational Inference)技术,以估计数据的隐藏状态。

在这篇文章中,我们将深入探讨 VAE 的理论基础、核心概念、算法原理以及实际应用。我们还将讨论 VAE 的优缺点、未来发展趋势和挑战。

1.1 自动编码器简介

自动编码器是一种神经网络架构,它包括一个编码器(Encoder)和一个解码器(Decoder)。编码器的作用是将输入的原始数据压缩为低维的隐藏表示,解码器的作用是将隐藏表示还原为原始数据的近似复制。

自动编码器的目标是最小化原始数据和解码器输出之间的差异,以实现数据压缩和降维。自动编码器还可以用于生成新的数据,特别是当训练数据集较小时,它可以生成更多的数据来增强模型的学习能力。

1.2 变分自动编码器简介

变分自动编码器是一种特殊类型的自动编码器,它使用变分推断技术估计数据的隐藏状态。VAE 的目标是最小化原始数据和解码器输出之间的差异,同时满足隐藏状态的概率分布约束。这种约束使得 VAE 可以生成更自然、连贯的数据。

VAE 的核心思想是将数据生成过程模型为一个概率模型,这使得 VAE 可以在生成过程中采样,从而实现数据生成的随机性。

1.3 变分自动编码器的应用

VAE 在多个领域得到了广泛应用,包括图像生成、文本生成、语音合成、生物信息分析、医疗图像诊断等。VAE 还可以用于降维和数据压缩任务,例如图像压缩、文本摘要等。

在这篇文章中,我们将深入探讨 VAE 的理论基础、核心概念、算法原理以及实际应用。我们还将讨论 VAE 的优缺点、未来发展趋势和挑战。

2.核心概念与联系

2.1 变分推断

变分推断是一种用于估计隐变量的方法,它将隐变量的推断转化为一个优化问题,通过最小化一个变分对偶对象来估计隐变量。变分推断通常用于估计概率图模型中的隐变量,例如隐马尔可夫模型、贝叶斯网络等。

在 VAE 中,变分推断用于估计数据的隐藏状态,同时满足隐藏状态的概率分布约束。这种约束使得 VAE 可以生成更自然、连贯的数据。

2.2 概率图模型

概率图模型是一种用于表示随机变量之间关系的模型,它可以用来描述数据生成过程的概率分布。概率图模型包括贝叶斯网络、马尔可夫网络、图模型等。

在 VAE 中,我们使用了一种称为生成对偶模型(Generative Adversarial Model,GAN)的概率图模型。GAN 是一种生成对抗性学习框架,它包括一个生成器(Generator)和一个判别器(Discriminator)。生成器的作用是生成新的数据,判别器的作用是判断生成的数据是否与真实数据相似。

2.3 生成对偶模型

生成对偶模型是一种生成数据的概率图模型,它包括一个生成器和一个判别器。生成器的作用是生成新的数据,判别器的作用是判断生成的数据是否与真实数据相似。GAN 的目标是使生成器能够生成与真实数据相似的数据,从而使判别器无法准确地判断生成的数据是否为真实数据。

在 VAE 中,我们使用了一种称为生成对偶模型(Generative Adversarial Network,GAN)的概率图模型。GAN 是一种生成对抗性学习框架,它包括一个生成器(Generator)和一个判别器(Discriminator)。生成器的作用是生成新的数据,判别器的作用是判断生成的数据是否与真实数据相似。

3.核心算法原理和具体操作步骤以及数学模型公式详细讲解

3.1 算法原理

VAE 的核心思想是将数据生成过程模型为一个概率模型,这使得 VAE 可以在生成过程中采样,从而实现数据生成的随机性。VAE 的目标是最小化原始数据和解码器输出之间的差异,同时满足隐藏状态的概率分布约束。

VAE 的算法原理如下:

- 定义一个生成对偶模型(GAN),其中生成器是一个 VAE。

- 使用变分推断技术估计数据的隐藏状态。

- 最小化原始数据和解码器输出之间的差异,同时满足隐藏状态的概率分布约束。

3.2 具体操作步骤

VAE 的具体操作步骤如下:

- 定义一个生成对偶模型(GAN),其中生成器是一个 VAE。

- 使用变分推断技术估计数据的隐藏状态。

- 最小化原始数据和解码器输出之间的差异,同时满足隐藏状态的概率分布约束。

3.3 数学模型公式详细讲解

VAE 的数学模型公式如下:

- 数据生成过程:

$$ p{\theta}(x) = \int p{\theta}(x|z)p(z)dz $$

- 隐藏状态的概率分布约束:

$$ q{\phi}(z|x) = \mathcal{N}(z|m{\phi}(x), \text{diag}(s_{\phi}(x))) $$

- 编码器(Encoder):

$$ m{\phi}(x) = \sigma(W1[x] + b_1) $$

$$ s{\phi}(x) = \text{softplus}(W2[x] + b_2) $$

- 解码器(Decoder):

$$ \hat{x} = \mu{\theta}(z) = W3z + b_3 $$

- 变分对偶对象:

$$ \log p{\theta}(x) \geq \mathbb{E}{q{\phi}(z|x)}\left[\log \frac{p{\theta}(x,z)}{q{\phi}(z|x)}\right] - D{\text{KL}}(q_{\phi}(z|x)||p(z)) $$

- 最小化变分对偶对象:

$$ \min{\phi} \max{\theta} \left[\mathbb{E}{q{\phi}(z|x)}\left[\log \frac{p{\theta}(x,z)}{q{\phi}(z|x)}\right] - D{\text{KL}}(q{\phi}(z|x)||p(z))\right] $$

其中,$p{\theta}(x|z)$ 是数据生成过程,$p(z)$ 是隐藏状态的先验分布,$q{\phi}(z|x)$ 是变分推断的隐藏状态估计,$\theta$ 和 $\phi$ 分别是生成器和解码器的参数。

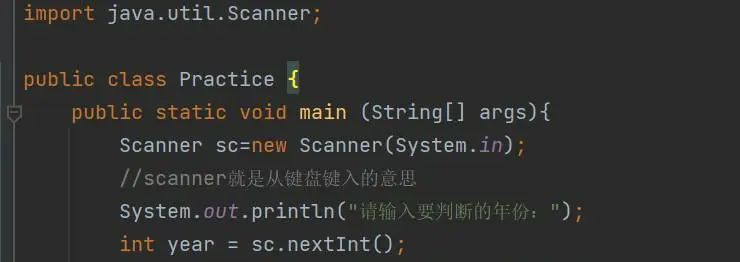

4.具体代码实例和详细解释说明

在这个部分,我们将通过一个简单的例子来展示 VAE 的实际应用。我们将使用 Python 和 TensorFlow 来实现 VAE。

首先,我们需要导入所需的库:

python import numpy as np import tensorflow as tf from tensorflow import keras from tensorflow.keras import layers

接下来,我们定义 VAE 的生成器(Encoder)和解码器(Decoder):

```python class Encoder(layers.Layer): def call(self, inputs): x = layers.Dense(128)(inputs) x = layers.LeakyReLU()(x) x = layers.Dense(64)(x) x = layers.LeakyReLU()(x) zmean = layers.Dense(2)(x) zlogvar = layers.Dense(2)(x) return zmean, zlogvar

class Decoder(layers.Layer): def call(self, inputs): x = layers.Dense(64)(inputs) x = layers.LeakyReLU()(x) x = layers.Dense(128)(x) x = layers.LeakyReLU()(x) x = layers.Dense(784)(x) x = layers.reshape(x, (28, 28)) return x ```

接下来,我们定义 VAE 的训练过程:

```python def vaemodel(encoder, decoder, latentdim): inputs = keras.Input(shape=(784,)) zmean, zlogvar = encoder(inputs) z = layers.KLDivergence(betaapproximation='logstd')([tf.oneslike(zmean), zlogvar]) z = layers.RepeatVector(10)(layers.Reshape((latentdim,))(z)) xreconstructed = decoder(z) vaeloss = tf.reducemean(tf.reducesum(tf.square(xreconstructed - inputs), axis=[1, 2, 3])) vaeloss += -0.5 * tf.reducesum(1 + zlogvar - tf.square(zmean) - tf.exp(zlogvar)) vae = keras.Model(inputs, xreconstructed, name='VAE') vae.compile(optimizer='adam') return vae, vaeloss

vae, vaeloss = vaemodel(Encoder(), Decoder(), latent_dim=2) ```

接下来,我们训练 VAE:

python x_train = np.random.normal(size=(10000, 784)) vae.fit(x_train, x_train, epochs=10, batch_size=256, shuffle=True, validation_split=0.1)

通过这个简单的例子,我们可以看到 VAE 的实际应用过程。在实际应用中,我们可以根据具体问题和数据集来调整 VAE 的结构和参数。

5.未来发展趋势与挑战

未来,VAE 的发展趋势和挑战包括:

- 提高 VAE 的表示能力和学习效率。目前,VAE 在某些任务上的表示能力和学习效率仍然有待提高。为了提高 VAE 的表示能力和学习效率,我们可以尝试使用更复杂的神经网络结构、更好的优化算法和更有效的正则化方法。

- 研究 VAE 的理论基础。目前,VAE 的理论基础仍然存在一定的不明确,例如隐藏状态的概率分布约束的泛化性和可解释性。为了更好地理解 VAE 的工作原理,我们需要进一步研究 VAE 的理论基础。

- 应用 VAE 到新的领域。目前,VAE 已经得到了广泛应用,但仍然有许多领域尚未充分利用 VAE 的潜力。例如,生物信息学、医疗图像诊断、自然语言处理等领域。我们需要不断探索新的应用领域,以便更好地发挥 VAE 的优势。

- 解决 VAE 的挑战。VAE 面临的挑战包括:生成的数据质量和多样性的提高、训练速度和计算成本的降低、隐藏状态的解释和可视化等。为了解决这些挑战,我们需要不断研究和优化 VAE 的算法和实现。

6.附录常见问题与解答

在这个部分,我们将回答一些常见问题:

- Q: VAE 与 GAN 的区别是什么? A: VAE 和 GAN 都是用于生成数据的概率图模型,但它们的目标和方法有所不同。VAE 的目标是最小化原始数据和解码器输出之间的差异,同时满足隐藏状态的概率分布约束。GAN 的目标是使生成器能够生成与真实数据相似的数据,从而使判别器无法准确地判断生成的数据是否为真实数据。

- Q: VAE 的隐藏状态是如何影响生成数据的质量的? A: VAE 的隐藏状态是生成数据的一部分,它们在生成过程中扮演着关键角色。隐藏状态的质量和多样性直接影响生成数据的质量和多样性。更好的隐藏状态可以生成更自然、连贯的数据。

- Q: VAE 的训练过程是如何进行的? A: VAE 的训练过程包括编码器(Encoder)和解码器(Decoder)的训练。编码器的目标是估计输入数据的隐藏状态,解码器的目标是从隐藏状态生成原始数据。VAE 的训练过程涉及到最小化原始数据和解码器输出之间的差异,同时满足隐藏状态的概率分布约束。

- Q: VAE 的应用范围是什么? A: VAE 的应用范围广泛,包括图像生成、文本生成、语音合成、生物信息分析、医疗图像诊断等。VAE 还可以用于降维和数据压缩任务,例如图像压缩、文本摘要等。

通过这篇文章,我们了解了 VAE 的基本概念、算法原理、应用和未来发展趋势。我们希望这篇文章能够帮助读者更好地理解 VAE 的工作原理和应用,并为未来的研究和实践提供启示。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)