深度探索:机器学习中的 条件生成对抗网络(Conditional GAN, CGAN)算法原理及其应用

条件生成对抗网络(CGAN)通过引入条件变量,实现了对生成样本属性的精准控制,极大地拓宽了GAN的应用范围。尽管训练难度和条件依赖性等问题尚待进一步解决,但CGAN已在图像生成、跨模态学习等多个领域取得了显著成果。随着研究的深入,未来有望在以下几个方向取得突破:稳定性和收敛性改进:研发新型训练策略和网络架构,提高CGAN的训练效率和稳定性。高级条件控制:探索更复杂的条件表示和融合机制,以应对高维度

目录

1. 引言与背景

生成对抗网络(Generative Adversarial Networks, GANs)作为一种深度学习框架,在无监督学习领域展现出强大的能力,特别在图像、音频、文本等复杂数据的生成任务中取得了显著成果。然而,原始GAN模型在生成过程中缺乏对生成样本特定属性的直接控制。为了赋予生成器更强的指导性和可控性,Mario Gómez-Bombarelli等人于2014年提出了条件生成对抗网络(Conditional GAN, CGAN)。本文将围绕CGAN展开深入探讨,涵盖其定理基础、算法原理、实现细节、优缺点分析、案例应用、与其他算法的对比,以及对未来发展的展望。

2. CGAN定理

CGAN的核心思想在于将额外的条件信息引入到原始GAN的架构中,使得生成器和判别器在训练过程中同时考虑条件变量。这主要基于两个关键定理:

定理1(GAN的零和博弈性质):在理想情况下,GAN的训练过程可视为生成器G与判别器D之间的一种零和博弈,当两者达到纳什均衡时,生成器能够生成与真实数据分布无法区分的样本。

定理2(CGAN的条件分布匹配):CGAN的目标是使生成器G在给定条件变量c的情况下,生成的数据分布逼近真实数据在相同条件c下的分布,即P(G(z|c)) ≈ P(X|c),其中z为噪声输入,X为真实数据。

3. 算法原理

CGAN在标准GAN的基础上引入了条件变量c,扩展了生成器和判别器的输入空间:

-

生成器G:接收到噪声z与条件变量c作为输入,生成与条件c相关的样本G(z|c)。条件c可以是类别标签、文本描述、图像属性等多种形式。

-

判别器D:不仅判断输入样本是否真实,还需预测其对应条件变量。其目标函数包含了两部分:一是识别真实样本与伪造样本的能力,二是对条件变量c的准确预测。

CGAN的损失函数由两部分组成:

-

生成器损失L_G:鼓励判别器D对生成样本G(z|c)及相应条件c的判断为“真实”,即最大化log(D(G(z|c), c))。

-

判别器损失L_D:鼓励D正确区分真实样本(X, c)与生成样本(G(z|c), c),即最小化E_{(X,c)P(X,c)}[log(D(X,c))] - E_{zP(z)}[log(1-D(G(z|c), c)))]。

4. 算法实现

在实现CGAN时,通常遵循以下步骤:

-

数据预处理:整理包含条件变量的数据集,如对图像进行归一化处理,并将类别标签编码为one-hot向量。

-

网络结构设计:构建具有条件输入的生成器和判别器网络。对于条件变量c,可以将其直接拼接到噪声z或特征映射上,也可以通过额外的嵌入层处理。

-

训练流程: a. 随机抽取噪声z与条件变量c。 b. 生成器生成样本G(z|c)。 c. 判别器分别对真实样本(X, c)与生成样本(G(z|c), c)进行判断,并计算损失。 d. 更新判别器参数以最小化D的损失。 e. 固定判别器参数,更新生成器参数以最小化G的损失。 f. 循环以上步骤直至收敛。

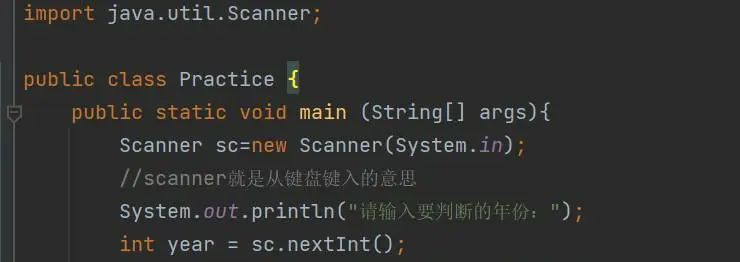

在Python中实现条件生成对抗网络(CGAN)通常会利用深度学习框架,如PyTorch。以下是一个基于PyTorch的CGAN实现示例,包括详细的代码讲解:

Python

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

# 定义超参数

batch_size = 128

latent_dim = 100

num_epochs = 100

learning_rate = 0.0002

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 数据预处理与加载

transform = transforms.Compose([transforms.Resize((64, 64)),

transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))])

dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

dataloader = torch.utils.data.DataLoader(dataset, batch_size=batch_size, shuffle=True)

# 定义条件变量(此处为MNIST数据集的类别标签,采用one-hot编码)

class_labels = torch.eye(10).to(device)

# 定义生成器G和判别器D

class Generator(nn.Module):

def __init__(self):

super().__init__()

self.main = nn.Sequential(

nn.ConvTranspose2d(latent_dim + 10, 512, 4, 1, 0, bias=False),

nn.BatchNorm2d(512),

nn.ReLU(True),

nn.ConvTranspose2d(512, 256, 4, 2, 1, bias=False),

nn.BatchNorm2d(256),

nn.ReLU(True),

nn.ConvTranspose2d(256, 128, 4, 2, 1, bias=False),

nn.BatchNorm2d(128),

nn.ReLU(True),

nn.ConvTranspose2d(128, 1, 4, 2, 1, bias=False),

nn.Tanh()

)

def forward(self, noise, labels):

# 将条件变量(类别标签)与噪声输入拼接

input = torch.cat((noise, labels), dim=1)

return self.main(input)

class Discriminator(nn.Module):

def __init__(self):

super().__init__()

self.main = nn.Sequential(

nn.Conv2d(1 + 10, 64, 4, 2, 1, bias=False),

nn.LeakyReLU(0.2, inplace=True),

nn.Conv2d(64, 128, 4, 2, 1, bias=False),

nn.BatchNorm2d(128),

nn.LeakyReLU(0.2, inplace=True),

nn.Conv2d(128, 256, 4, 2, 1, bias=False),

nn.BatchNorm2d(256),

nn.LeakyReLU(0.2, inplace=True),

nn.Conv2d(256, 1, 4, 1, 0, bias=False)

)

def forward(self, images, labels):

# 将条件变量(类别标签)与图像拼接

input = torch.cat((images, labels), dim=1)

return self.main(input).squeeze()

generator = Generator().to(device)

discriminator = Discriminator().to(device)

# 定义优化器

optimizer_G = optim.Adam(generator.parameters(), lr=learning_rate, betas=(0.5, 0.999))

optimizer_D = optim.Adam(discriminator.parameters(), lr=learning_rate, betas=(0.5, 0.999))

# 训练循环

for epoch in range(num_epochs):

for i, (images, labels) in enumerate(dataloader):

real_labels = class_labels[labels].unsqueeze(1).unsqueeze(1).expand(-1, -1, images.shape[2], images.shape[3])

# 训练判别器D

discriminator.zero_grad()

real_images = images.to(device)

real_outputs = discriminator(real_images, real_labels)

real_loss = nn.functional.binary_cross_entropy_with_logits(real_outputs, torch.ones_like(real_outputs))

noise = torch.randn(batch_size, latent_dim, 1, 1).to(device)

fake_labels = torch.randint(0, 10, (batch_size,), device=device)

fake_images = generator(noise, class_labels[fake_labels]).detach()

fake_labels_onehot = class_labels[fake_labels].unsqueeze(1).unsqueeze(1).expand(-1, -1, fake_images.shape[2], fake_images.shape[3])

fake_outputs = discriminator(fake_images, fake_labels_onehot)

fake_loss = nn.functional.binary_cross_entropy_with_logits(fake_outputs, torch.zeros_like(fake_outputs))

d_loss = real_loss + fake_loss

d_loss.backward()

optimizer_D.step()

# 训练生成器G

generator.zero_grad()

fake_labels = torch.randint(0, 10, (batch_size,), device=device)

noise = torch.randn(batch_size, latent_dim, 1, 1).to(device)

fake_images = generator(noise, class_labels[fake_labels])

fake_labels_onehot = class_labels[fake_labels].unsqueeze(1).unsqueeze(1).expand(-1, -1, fake_images.shape[2], fake_images.shape[3])

g_outputs = discriminator(fake_images, fake_labels_onehot)

g_loss = nn.functional.binary_cross_entropy_with_logits(g_outputs, torch.ones_like(g_outputs))

g_loss.backward()

optimizer_G.step()

# 打印损失和进度

if (i + 1) % 100 == 0:

print(f'Epoch [{epoch}/{num_epochs}], Step [{i+1}/{len(dataloader)}], '

f'D Loss: {real_loss.item():.4f} + {fake_loss.item():.4f} = {d_loss.item():.4f}, '

f'G Loss: {g_loss.item():.4f}')

# 保存模型

torch.save(generator.state_dict(), 'cgan_generator.pth')

torch.save(discriminator.state_dict(), 'cgan_discriminator.pth')代码讲解:

-

导入所需库:导入

torch、torch.nn、torch.optim以及torchvision.datasets和transforms模块,用于构建和训练模型、加载数据集以及对数据进行预处理。 -

定义超参数:设置批量大小、潜在维度(噪声输入维度)、训练轮数、学习率等参数,以及设备类型(GPU或CPU)。

-

数据预处理与加载:使用

transforms.Compose定义一系列转换操作(如调整图像大小、转为张量、标准化像素值),并应用到MNIST数据集上。使用DataLoader创建数据加载器,方便批量训练。 -

条件变量:为MNIST数据集的10个类别创建one-hot编码标签矩阵,便于与噪声或图像拼接。

-

定义生成器G和判别器D:

Generator类继承自nn.Module,包含一个卷积转置网络(用于上采样)。其forward方法接收噪声和条件标签作为输入,将它们拼接后送入网络生成图像。Discriminator类同样继承自nn.Module,包含一个卷积网络(用于下采样)。其forward方法接收图像和条件标签作为输入,将它们拼接后送入网络判断图像真伪。

-

初始化模型与优化器:

- 实例化生成器和判别器,并将其移动至指定设备(GPU或CPU)。

- 使用

Adam优化器为生成器和判别器分别创建优化器实例。

-

训练循环:

- 对每个训练轮次(epoch)中的每个批次(batch)执行以下操作:

- 训练判别器D:

- 清零判别器梯度。

- 加载真实图像及其对应的one-hot编码标签,计算判别器对真实图像的输出。使用二元交叉熵计算真实图像的损失。

- 生成一组随机噪声和类别标签,通过生成器生成假图像。计算判别器对假图像的输出。使用二元交叉熵计算假图像的损失。

- 合并真实图像和假图像的损失,反向传播更新判别器参数。

- 训练生成器G:

- 清零生成器梯度。

- 生成一组新的随机噪声和类别标签,通过生成器生成假图像。计算判别器对这些假图像的输出。使用二元交叉熵计算生成器损失,目标是使判别器认为生成的图像为真。

- 反向传播更新生成器参数。

- 打印损失与进度:每隔一定步数打印当前的判别器损失和生成器损失,以及训练进度。

- 训练判别器D:

- 对每个训练轮次(epoch)中的每个批次(batch)执行以下操作:

-

保存模型:训练完成后,保存生成器和判别器的权重状态,以便后续使用。

以上代码实现了CGAN的训练过程,通过条件变量(类别标签)控制生成器

5. 优缺点分析

优点:

- 可控生成:CGAN允许用户指定生成样本的特定属性,提高了生成任务的针对性和灵活性。

- 跨模态生成:条件变量可以是不同模态的数据,如文本描述生成图像,实现了跨模态的联合学习。

- 潜在应用广泛:在图像编辑、风格迁移、数据增强、虚拟现实等领域展现出巨大潜力。

缺点:

- 训练难度:与标准GAN相似,CGAN也可能面临训练不稳定、模式塌陷等问题,需要精细的超参数调整和训练策略。

- 条件依赖性:生成质量高度依赖于条件变量的表达能力和质量,对于复杂、高维的条件变量处理能力有限。

6. 案例应用

图像合成:CGAN成功应用于人脸图像生成,如CelebA数据集上的年龄、性别、表情条件合成;在COCO-Stuff数据集上,根据文本描述生成对应场景图像。

图像翻译:Pix2Pix利用CGAN实现图像到图像的翻译任务,如将灰度图像转为彩色、地图转为卫星图像等。

3D模型生成:在ShapeNet数据集上,CGAN生成具有特定类别标签的3D模型,如飞机、汽车等。

7. 对比与其他算法

-

与标准GAN对比:CGAN增加了条件控制,增强了生成任务的针对性和实用性,而标准GAN仅能生成未标记数据的随机样本。

-

与VAE(变分自编码器)对比:VAE同样可以生成新样本,但其生成过程是确定性的,且通常生成质量不如CGAN。而CGAN通过对抗训练得到更高质量样本,但可能面临训练不稳定问题。

8. 结论与展望

条件生成对抗网络(CGAN)通过引入条件变量,实现了对生成样本属性的精准控制,极大地拓宽了GAN的应用范围。尽管训练难度和条件依赖性等问题尚待进一步解决,但CGAN已在图像生成、跨模态学习等多个领域取得了显著成果。随着研究的深入,未来有望在以下几个方向取得突破:

- 稳定性和收敛性改进:研发新型训练策略和网络架构,提高CGAN的训练效率和稳定性。

- 高级条件控制:探索更复杂的条件表示和融合机制,以应对高维度、非线性条件变量。

- 跨模态和多任务学习:结合更多模态数据,实现更丰富的跨模态生成任务,并在单一模型中处理多种生成任务。

- 实际应用拓展:在医疗影像、虚拟现实、艺术创作等领域开发更具创新性和实用价值的应用。

总之,CGAN作为生成对抗网络的重要分支,以其独特的条件控制能力在机器学习领域占据重要地位,持续推动着无监督学习技术的发展与创新。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)