深度学习中的循环神经网络(RNN)

本文介绍了深度学习中循环神经网络(RNN)的基本知识点,包括RNN的原理、应用场景以及使用Python和TensorFlow库实现简单RNN的代码示例。RNN作为一种具有记忆能力的神经网络模型,在序列数据处理中具有重要的应用价值。接下来我们将通过rnn模型来进行更多有趣的实战。

深度学习在许多领域都取得了巨大的成功,而其中一个重要的组成部分就是循环神经网络(Recurrent Neural Network,RNN)。RNN是一种用于处理序列数据的神经网络模型,具有记忆能力,适用于自然语言处理、语音识别、时间序列预测等任务。

RNN与CNN区别

RNN(循环神经网络)和CNN(卷积神经网络)是深度学习中常用的两种神经网络结构,它们分别适用于不同类型的数据和任务,并在结构和应用上有一些显著的区别。

1. 结构和原理的区别

-

RNN(循环神经网络):

- RNN是一种适用于处理序列数据的神经网络结构,具有记忆能力。

- RNN的计算过程是基于时间步的,每个时间步的输出会作为下一个时间步的输入,因此可以处理变长序列数据。

- RNN的隐藏状态在时间上是共享的,能够捕捉到序列数据中的时序信息,适用于自然语言处理、时间序列预测等任务。

-

CNN(卷积神经网络):

- CNN是一种适用于处理网格状数据(如图像)的神经网络结构,具有平移不变性。

- CNN通过卷积层和池化层来提取图像中的局部特征,并且参数共享和池化操作使得CNN对图像的平移、缩放等变换具有一定的鲁棒性。

- CNN适用于图像识别、物体检测、图像分割等任务,能够有效地处理二维数据。

2. 应用场景的区别

-

RNN的应用场景:

- RNN适用于处理序列数据,如自然语言文本、时间序列数据、音频数据等。

- 典型的应用包括语言建模、机器翻译、情感分析、股票预测等领域。

-

CNN的应用场景:

- CNN适用于处理网格状数据,如图像、视频等。

- 典型的应用包括图像分类、对象检测、人脸识别、医学影像分析等领域。

3. 参数共享和记忆能力的区别

-

参数共享:

- CNN通过卷积操作实现了参数共享,可以有效地减少模型参数数量,降低过拟合风险。

- RNN虽然也可以实现参数共享,但其主要特点是隐藏状态的时间共享,能够捕捉序列数据中的时序信息。

-

记忆能力:

- RNN具有记忆能力,可以通过隐藏状态来记忆先前的信息,适用于需要考虑上下文信息的任务。

- CNN在一定程度上也具有局部信息的记忆能力,但并不像RNN那样直接建模序列数据中的依赖关系。

4. 结合使用

在一些复杂任务中,还可以将RNN和CNN结合起来使用,比如在图像描述生成任务中,可以使用CNN来提取图像特征,然后将这些特征输入给RNN来生成描述语句。

RNN原理

RNN是一种具有时间反馈的神经网络模型,可以使用它来处理变长的序列数据。与传统的前馈神经网络不同,RNN在处理每个时间步的输入时,还会考虑上一个时间步的输出。这种时间反馈机制使得RNN能够对序列中的上下文信息进行建模。

RNN的计算过程是基于时间步的,每个时间步的输出会作为下一个时间步的输入,因此可以处理变长序列数据。具体来说,RNN的计算可以表示为以下几个步骤:

-

初始化隐藏状态:在时间步 t=0,RNN会接收到一个初始的隐藏状态ℎ0,通常初始化为全零向量或者通过学习得到。

-

输入计算:对于每个时间步 t,RNN接收到一个输入xt,例如序列中的一个元素或者一段文本中的一个词。RNN会根据当前时间步的输入xt以及前一个时间步的隐藏状态ht−1来计算当前时间步的隐藏状态ht。

-

隐藏状态更新:RNN通过一个激活函数(通常是tanh函数)对线性变换的结果进行非线性映射,得到当前时间步的隐藏状态ht。这个隐藏状态可以看作是网络对先前输入信息的记忆。

-

输出计算:根据当前时间步的隐藏状态ht,可以计算得到当前时间步的输出yt。具体的输出计算方式可以根据任务的不同而定,例如分类任务可以使用softmax函数进行多分类概率预测。

-

重复操作:根据上述步骤,RNN会对序列中的每个时间步进行相同的操作,不断更新隐藏状态并计算输出。这样就可以在序列数据中建立起时间上的依赖关系。

RNN的隐藏状态在时间上是共享的,它能够捕捉到序列数据中的时序信息,并且通过反向传播算法可以学习到适合任务的模型参数。然而,传统的RNN存在梯度消失和梯度爆炸等问题,为了解决这些问题,出现了一些改进的RNN结构,如长短期记忆网络(LSTM)和门控循环单元(GRU)。如下是花书的RNN网络架构图:

RNN的应用场景

RNN在自然语言处理中有许多应用。例如,语言模型可以使用RNN来预测下一个单词;机器翻译可以使用RNN来将一种语言翻译成另一种语言;情感分析可以使用RNN来判断一段文本的情感倾向等。此外,RNN还可以应用于音频处理、视频分析、股票预测等领域。

RNN实战

简单的字符级RNN模型

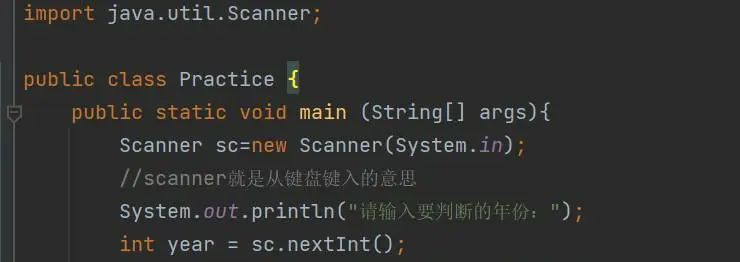

下面是一个使用Python和TensorFlow库实现简单RNN的示例代码:

import numpy as np

import tensorflow as tf

# 定义输入序列和目标序列

input_seq = ['hello', 'world', 'tensorflow']

target_seq = ['elloh', 'orldw', 'ensorflo']

# 构建字符映射表

unique_chars = list(set(''.join(input_seq)))

char_to_idx = {ch: i for i, ch in enumerate(unique_chars)}

idx_to_char = {i: ch for i, ch in enumerate(unique_chars)}

# 将输入和目标序列转换为索引序列

input_idx = [[char_to_idx[ch] for ch in seq] for seq in input_seq]

target_idx = [[char_to_idx[ch] for ch in seq] for seq in target_seq]

# 定义模型超参数

vocab_size = len(unique_chars)

hidden_units = 64

learning_rate = 0.1

# 构建RNN模型

model = tf.keras.Sequential([

tf.keras.layers.Embedding(vocab_size, hidden_units),

tf.keras.layers.SimpleRNN(hidden_units, return_sequences=True),

tf.keras.layers.TimeDistributed(tf.keras.layers.Dense(vocab_size, activation='softmax'))

])

# 编译模型

model.compile(optimizer=tf.keras.optimizers.Adam(learning_rate),

loss=tf.keras.losses.SparseCategoricalCrossentropy(),

metrics=['accuracy'])

# 将输入和目标序列转换为TensorFlow张量

input_tensor = tf.convert_to_tensor(input_idx)

target_tensor = tf.convert_to_tensor(target_idx)

# 训练模型

model.fit(input_tensor, target_tensor, epochs=100)

# 使用训练好的模型进行预测

input_test = ['hi', 'tensorflow']

input_test_idx = [[char_to_idx[ch] for ch in seq] for seq in input_test]

input_test_tensor = tf.convert_to_tensor(input_test_idx)

output_test = model.predict(input_test_tensor)

output_test_seq = [[idx_to_char[idx] for idx in seq] for seq in np.argmax(output_test, axis=-1)]

# 打印预测结果

for i in range(len(input_test)):

print(f'Input: {input_test[i]}, Output: {"".join(output_test_seq[i])}')

这段代码实现了一个简单的字符级RNN模型,用于将输入序列反转。它使用了TensorFlow库来搭建和训练模型。首先,定义了输入和目标序列,然后构建了字符到索引的映射表。接下来,通过Sequential模型来定义RNN结构,包括一个嵌入层、一个SimpleRNN层和一个TimeDistributed层。最后,使用训练数据对模型进行训练,并使用训练好的模型对测试数据进行预测。

总结

本文介绍了深度学习中循环神经网络(RNN)的基本知识点,包括RNN的原理、应用场景以及使用Python和TensorFlow库实现简单RNN的代码示例。RNN作为一种具有记忆能力的神经网络模型,在序列数据处理中具有重要的应用价值。接下来我们将通过rnn模型来进行更多有趣的实战。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)