深度探索:机器学习中的变分自编码器 (VAE)原理及其应用

变分自编码器作为一种有效的无监督学习和生成模型,凭借其理论完备性、良好的生成性能以及广泛的应用潜力,在机器学习领域占据重要地位。尽管存在如重构模糊、对复杂分布建模能力有限等缺点,但通过引入更先进的网络结构、优化损失函数设计、调整训练策略等方式,VAE的性能有望进一步提升。未来研究方向可能包括:探索新型变分推断方法:开发更高效、精确的变分推断技术,以改善潜变量分布的学习效果。结合其他深度学习技术:融

目录

1.引言与背景

在当今大数据时代,海量高维复杂数据的处理与分析成为机器学习领域的重要挑战。其中,有效地提取数据内在结构、进行降维、生成新数据以及进行无监督学习,是众多研究者和实践者关注的核心议题。变分自编码器(Variational Autoencoder, VAE)作为一种强大的深度学习模型,以其独特的理论基础、高效的建模能力及广泛的应用场景,在这一领域中脱颖而出。本文将系统地探讨VAE的理论基础、算法原理、实现细节、优缺点、实际应用案例,并与其他相关算法进行对比,最后对未来的研究方向进行展望。

2.定理

一般情况下,VAE的理论基础主要源于概率论、统计推断和变分推断。特别地,VAE的设计深受贝叶斯公式、KL散度以及变分推断原理的影响。补充定理,可以下几点:

-

贝叶斯公式:VAE本质上是一种基于贝叶斯框架的生成模型,其核心思想是通过联合分布p(x,z)来描述观测数据x和潜在变量z之间的关系,然后利用贝叶斯公式求解后验分布p(z∣x),从而揭示数据的潜在结构。

-

KL散度:VAE在优化过程中,利用KL散度衡量潜变量分布与先验分布之间的差异,作为正则化项融入损失函数,以此推动模型学习到更接近先验分布的潜变量分布。

-

变分推断原理:VAE的核心创新在于采用变分推断方法近似难以直接计算的后验分布p(z∣x)。通过引入一个可学习的参数化分布q(z∣x;ϕ)(即编码器),并最小化其与真实后验分布之间的KL散度,实现对后验分布的有效近似。

3.算法原理

VAE由两部分构成:编码器(Encoder)和解码器(Decoder)。其工作流程如下:

-

编码阶段:给定观测数据x,编码器网络(通常是神经网络)计算出其对应潜变量z的概率分布q(z∣x;ϕ),其中ϕ是编码器网络的参数。通常假设该分布为多元正态分布,由均值向量�μ和协方差矩阵Σ(或其对角线形式的方差σ²)刻画。

-

采样阶段:从上述分布中抽取一个样本

,通常采用重参数化技巧(Reparameterization Trick)保证梯度可以通过采样过程反向传播。

-

解码阶段:将采样的潜变量

输入解码器网络,生成重构数据

。解码器的目标是学习数据生成过程,即条件概率分布p(x∣z;θ),其中θ是解码器网络的参数。

4.算法实现

VAE的实现通常涉及以下几个关键步骤:

-

模型定义:使用Keras、PyTorch等深度学习框架搭建编码器和解码器网络,它们通常由多层感知机(MLP)、卷积神经网络(CNN)或循环神经网络(RNN)组成,取决于数据类型。

-

损失函数:VAE的损失函数由两部分构成:重构损失(Reconstruction Loss)和KL散度损失(KL Divergence Loss)。重构损失通常采用均方误差(MSE)或交叉熵(CE)衡量原始数据x与重构数据

的差异。KL散度损失则用来约束潜变量分布接近于预设的先验分布(通常为标准正态分布)。

综合起来,VAE的总损失函数为:

其中,β是平衡重构损失与KL散度损失的权重参数。

-

模型训练:使用梯度下降法(如Adam)优化VAE的总损失函数,更新编码器和解码器网络的参数ϕ和θ。

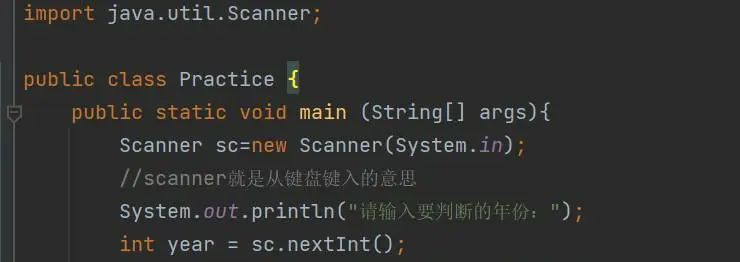

为了帮助理解并实现变分自编码器(VAE)在Python中的具体实现,我们将使用tensorflow库构建一个简单的VAE模型,用于处理二维的MNIST手写数字数据集。以下是一段详细的代码及其讲解:

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, Lambda

from tensorflow.keras.models import Model

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

from tensorflow.keras.losses import categorical_crossentropy

from tensorflow.keras.optimizers import Adam

import numpy as np

# Step 1: 数据预处理

(x_train, y_train), (x_test, y_test) = mnist.load_data()

x_train = x_train.astype('float32') / 255.

x_test = x_test.astype('float32') / 255.

x_train = x_train.reshape(-1, 784)

x_test = x_test.reshape(-1, 784)

# Step 2: 定义超参数

input_dim = 784 # 输入数据维度(MNIST图像像素数量)

latent_dim = 2 # 潜在空间维度(简化为二维以便可视化)

intermediate_dim = 256 # 编码器/解码器中间层神经元数量

batch_size = 100

epochs = 50

learning_rate = 0.001

# Step 3: 构建编码器网络

def build_encoder(input_dim, intermediate_dim, latent_dim):

inputs = Input(shape=(input_dim,))

x = Dense(intermediate_dim, activation='relu')(inputs)

z_mean = Dense(latent_dim)(x)

z_log_var = Dense(latent_dim)(x)

return Model(inputs=inputs, outputs=[z_mean, z_log_var])

encoder = build_encoder(input_dim, intermediate_dim, latent_dim)

# Step 4: 重参数化技巧(Reparameterization Trick)

def sampling(args):

z_mean, z_log_var = args

epsilon = tf.random.normal(shape=tf.shape(z_mean))

return z_mean + tf.exp(0.5 * z_log_var) * epsilon

sampling_layer = Lambda(sampling, output_shape=(latent_dim,))

# Step 5: 构建解码器网络

def build_decoder(latent_dim, intermediate_dim, input_dim):

inputs = Input(shape=(latent_dim,))

x = Dense(intermediate_dim, activation='relu')(inputs)

outputs = Dense(input_dim, activation='sigmoid')(x)

return Model(inputs=inputs, outputs=outputs)

decoder = build_decoder(latent_dim, intermediate_dim, input_dim)

# Step 6: 组合编码器、重参数化层与解码器,形成完整的VAE模型

latent_inputs = Input(shape=(latent_dim,))

decoded_outputs = decoder(latent_inputs)

vae = Model(inputs=encoder.inputs, outputs=decoder(encoder.outputs[0]))

vae.compile(optimizer=Adam(lr=learning_rate), loss=categorical_crossentropy)

# Step 7: 训练VAE模型

vae.fit(x_train, x_train,

shuffle=True,

epochs=epochs,

batch_size=batch_size,

validation_data=(x_test, x_test))

# Step 8: 保存模型

vae.save('vae_mnist_model.h5')代码讲解:

-

数据预处理:加载MNIST数据集,将其归一化到[0, 1]区间,并转化为一维向量以供模型输入。

-

定义超参数:设置模型参数,如输入维度、潜在维度、中间层神经元数量、批次大小、训练轮数以及学习率。

-

构建编码器网络:创建一个包含全连接层(ReLU激活)的神经网络,输出为潜在变量的均值(

z_mean)和对数方差(z_log_var)。 -

重参数化技巧:定义一个Lambda层,实现从均值和对数方差计算采样值的重参数化技巧。这样做的目的是使采样过程可微,使得模型可以通过反向传播更新参数。

-

构建解码器网络:创建一个与编码器结构相反的全连接神经网络,将潜在变量解码回原始数据空间,输出层使用Sigmoid激活函数以确保输出值在[0, 1]范围内。

-

组合编码器、重参数化层与解码器:将编码器、重参数化层和解码器连接起来,形成完整的VAE模型。编译模型时,使用交叉熵损失函数和Adam优化器。

-

训练VAE模型:使用训练集对VAE模型进行训练,并在验证集上评估性能。

-

保存模型:训练完成后,保存训练好的VAE模型,便于后续使用。

请注意,上述代码中损失函数使用了categorical_crossentropy,这是因为在示例中我们假设MNIST数据已经过one-hot编码处理。在实际应用中,如果数据未经one-hot编码,对于像MNIST这样的二值图像数据,重构损失通常会使用二元交叉熵(binary_crossentropy)。

这段代码展示了如何使用TensorFlow构建一个基本的VAE模型,并对其进行了训练。可以根据实际需求调整模型结构、超参数以及损失函数等。在完成训练后,可以使用训练好的VAE模型进行数据生成、降维可视化等任务。

5.优缺点分析

优点:

-

生成能力:VAE能够从学习到的潜在空间中生成新的、与训练数据类似的数据点,具有强大的数据生成能力。

-

无监督学习:VAE无需标注数据即可进行训练,适用于大量未标注数据的场景。

-

解释性:通过分析潜变量,可以揭示数据的潜在结构和模式,有助于理解数据生成过程。

-

可扩展性:VAE架构灵活,可以结合其他网络结构(如卷积、注意力机制等)适应不同类型的数据。

缺点:

-

模糊的重构:由于KL散度正则化的存在,VAE倾向于生成模糊的重构结果,牺牲细节以换取全局结构的准确捕捉。

-

学习复杂的分布困难:对于某些复杂分布的数据,VAE可能难以准确建模,特别是当潜变量维度较低时。

-

依赖于先验分布的选择:VAE性能受先验分布选择影响较大,不合适的选择可能导致模型表现不佳。

6.案例应用

VAE已被广泛应用于多个领域:

-

图像生成:VAE能生成与训练集风格相似的新图像,如人脸、手写数字、卡通人物等。

-

数据压缩与去噪:利用VAE对高维数据进行编码解码,实现数据的有效压缩与去噪。

-

异常检测:通过比较重构误差,VAE可用于识别与训练数据显著不同的异常样本。

-

半监督学习与迁移学习:结合少量标签数据,VAE可用于半监督分类任务;其学到的通用特征也可用于迁移学习。

7.对比与其他算法

VAE与其它生成模型(如GAN、PixelRNN/CNN等)的主要区别在于:

-

与GAN相比:VAE侧重于学习数据的全局分布,生成结果稳定但可能较模糊;GAN通过对抗训练生成高质量样本,但训练过程不稳定且缺乏明确的潜变量表示。

-

与PixelRNN/CNN等确定性模型相比:VAE引入了随机性,能够生成多样化的样本;而确定性模型往往生成结果单一,但可能在重构精度上优于VAE。

8.结论与展望

变分自编码器作为一种有效的无监督学习和生成模型,凭借其理论完备性、良好的生成性能以及广泛的应用潜力,在机器学习领域占据重要地位。尽管存在如重构模糊、对复杂分布建模能力有限等缺点,但通过引入更先进的网络结构、优化损失函数设计、调整训练策略等方式,VAE的性能有望进一步提升。未来研究方向可能包括:

-

探索新型变分推断方法:开发更高效、精确的变分推断技术,以改善潜变量分布的学习效果。

-

结合其他深度学习技术:融合注意力机制、自监督学习、图神经网络等前沿技术,提升VAE在特定任务或复杂数据上的表现。

-

跨模态学习:研究VAE在多模态数据(如文本-图像、语音-文本等)上的建模能力,推动跨模态生成与理解的发展。

综上所述,VAE作为一种强大的深度学习模型,将持续在数据挖掘、生成艺术、故障诊断、医学影像等诸多领域发挥重要作用,并随着研究的深入,展现出更加广阔的应用前景。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)